Un conte de Noël illustré1 en quatre actes :

- I. L’objectif

- II. La valise

- III. Les Chinois

- IV. Nous sommes Les Chinois

L’objectif

Antoine était de passage à Tokyo. Un type de son labo a cru bon de me demander un service (ERREUR ! il jura qu’on ne l’y reprît plus).

Bref, j’ai commandé sur Amazon une lentille d’appareil photo (50000 ¥ le machin). Le truc était censé arriver 5 jours plus tard.

À la fin du séjour d’Antoine, toujours pas de nouvelles d’Amazon.

Finalement, deux semaines plus tard, je reçois un mail (en japonais) disant : « Lol on vient de recevoir l’objectif en fait, on vous l’envoie. » Objectif reçu.

La valise

Je devais me rendre à Paris pour la thèse de littérature de Morpheen et une séance du Club-Méta.

Escale à l’aéroport Pudong de Shanghai (à minuit, sobre). Au moment d’entrer dans le 2e avion, je me rends compte qu’il me manque quelque chose et qu’il faut que je fasse demi-tour. Nous sommes à 15 minutes du décollage.

L’équipage m’accompagne. Sur le chemin, le stewart me demande :

— Vous avez oublié quoi ?

— Ma valise.

— Votre VALISE ?

On fait marche arrière, on repasse les portes d’embarquement. L’équipage nous dit de nous dépêcher. Je me rends compte que ma valise n’est pas aux portes, comme je le croyais. Je me dis que je l’ai sûrement laissée dans les toilettes, ou carrément au contrôle de sécurité, ou carrément dans le 1er avion.

L’équipage me fait signe que je ne peux pas aller trop loin, donc on remonte dans l’avion. Je suis décontenancé. Le stewart, sympa, me donne le numéro X des objets trouvés de l’aéroport.

Les Chinois

Arrivé à Paris, je tente le service de réclamation des bagages, en sachant pertinemment que la valise était un bagage à main, et donc que tout était bien de ma faute (même si le bagage a été volé). Mon interlocutrice le savait, mais elle a eu la sympathie d’essayer quand même.

Je téléphone en VoIP au numéro X des objets trouvés, décris ma situation en anglais. On me renvoie vers un numéro Y.

— For English press 2.

— *appuie sur 2*

— For baggage inquiry press 1.

— *appuie sur 1*

— *quelque chose en Chinois* puis ça raccroche.

Je réessaie plusieurs fois, même format. Du coup, j’essaie d’envoyer un mail. En anglais, et en Google-Translated chinois.

Soudain, l’illumination : je me rends compte que deux jours plus tard, je rentrerai par le même aéroport. Tout n’est donc pas perdu.

Une fois de retour à Shanghai donc, je me rends aux objets trouvés.

— Qu’est-ce qu’il y a dans votre valise ?

— Un Pikachu.

— Quoi d’autre ?

— Une caméra.

— Pas de caméra.

— ??? Vous n’avez rien ?

— Non.

Je me dis que j’ai peut-être raté l’entretien en disant « caméra » plutôt que « lentille », mais j’essayais de lui retranscrire ça pêle-mêle, aussi.

Je vais voir le guichet de la compagnie aérienne et leur dis que j’ai peut-être laissé une valise dans mon premier vol. Ils téléphonent, et me disent que non.

… De retour au Japon, je demande à ma fiancée de téléphoner au numéro X des objets trouvés. On la redirige vers le numéro Y qui lui raccroche au nez. Mais comme elle parle chinois ❤️, elle me donne deux informations supplémentaires :

— le numéro Y est celui de la compagnie ;

— le message en chinois disait : « Merci pour votre appel, bon voyage, au revoir ! » Sans intervention humaine, juste après avoir sélectionné le bon service en appuyant sur les touches du téléphone.

Ça semblait limpide : puisque j’avais oublié une valise (même après avoir bien dit « carry-on »), c’était trop facile pour eux de me rediriger vers le numéro de la compagnie aérienne.

Nous sommes Les Chinois

Lundi 16 décembre. À l’université de Kyoto, je demande à un pote thésard chinois de téléphoner aux objets trouvés pour moi. Je lui précise qu’il y a sûrement 5 % de chances que ça marche (puisque j’y suis allé moi-même, et que ma fiancée les a eus au téléphone) mais que je veux les tenter quand même.

Il appelle le numéro X, commence à décrire la situation. Puis il me demande :

— Est-ce un bagage à main ?

— Oui.

(On patiente cinq minutes.)

— Quelle est la couleur de la trousse de toilette ?

— Gris.

Puis il se met à griffonner des informations en chinois. Je me dis que c’est pas possible. Pour poser une question pareille, ils doivent avoir retrouvé ma valise. On n’est pas passés par la case « compagnie aérienne prison ». On gagne 50000 ¥.

— Il faut que tu ailles leur remettre ce numéro.

— ILS ONT RETROUVÉ MA VALISE ???

— Ah, oui. J’aurais dû commencer par ça.

Mon ami me précise qu’ils peuvent garder la valise 6 mois, que je peux la chercher moi-même ou envoyer quelqu’un, et qu’il faut que je leur donne son numéro de téléphone en guise d’identification. Je songe alors à mon cousin, qui s’y rendra dans quelques mois.

Jeudi 19 décembre. Un collègue chinois à Tokyo me demande : « Hey, pourquoi avais-tu besoin de moi l’autre jour ? » Je lui raconte toute l’histoire et lui précise : « Je voulais que tu appelles les objets trouvés de l’aéroport de Shanghai pour moi, mais t’inquiète ! je n’en ai plus besoin. »

Puis je continue :

— Au fait, demain c’est mon dernier jour de l’année, ce serait bien qu’on parle recherche quand même.

— Oui, déjeunons ensemble, parce que le soir je dîne avec des amis qui viennent de Shanghai. Attends. Ils viennent de SHANGHAI. Je vais les contacter tout de suite.

— Oh bon sang. S’ils y parviennent, it will be CHRISTMAS!!!

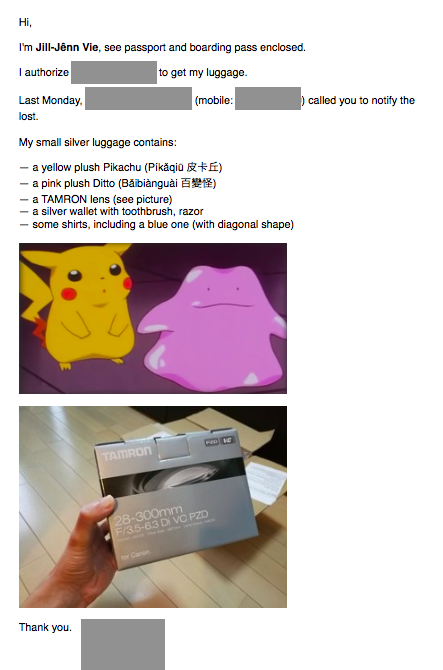

Je prépare à toute allure tous les papiers :

C’est la lettre originale. Vous noterez que j’ai pris soin de traduire les noms des peluches Pokémon en anglais et chinois.

- copie de mon passeport

- copie de ma carte d’embarquement (optionnel, mais mieux)

Vendredi 20 décembre. Le lendemain matin, les amis de mon collègue se rendent au service des objets trouvés avec tous les papiers. Problème, leur interlocuteur ne reconnaît pas le numéro de mon ami thésard à Kyoto. Du coup, ils téléphonent au numéro que je leur ai donné, et tombent sur une femme (??!). Je commence à perdre espoir, si près du but !

Puis finalement, par Messenger interposé, je réponds à toutes les questions de leur interlocuteur (où ai-je oublié ma valise et à quelle heure, pour prendre quel vol),

et……… ILS RÉCUPÈRENT MA VALISE !!

Le soir, ils me l’ont rendue au labo !

Conclusion

Le Père Noël existe !!! Et il est chinois !! Joyeux Noël !

-

Sinon, les gens lisent pas. ↩