Mindblown

Voici les œuvres qui m’ont profondément marqué au cours de cette décennie :

(Sans surprise, c’est la lettre M qui est au milieu.)

- Ubik de Philip K. Dick (1966, roman)

- Flowers for Algernon de Daniel Keyes (1966, roman)

- Eight Concert Etudes for piano de Nikolai Kapustin (1984), pas dans la fresque ci-dessus

- Cowboy Bebop de Shinichiro Watanabe (1998, série et 2001, film)

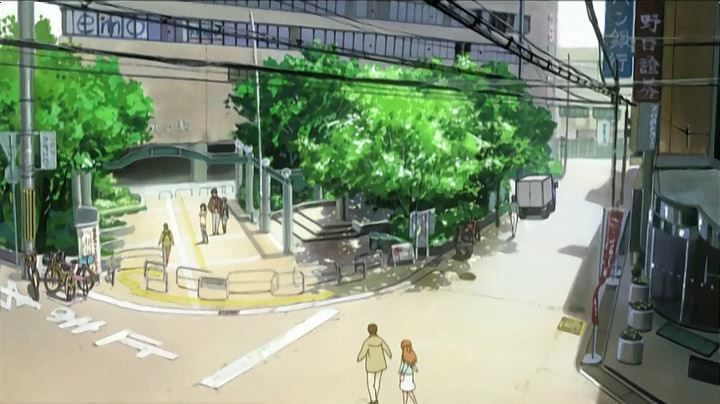

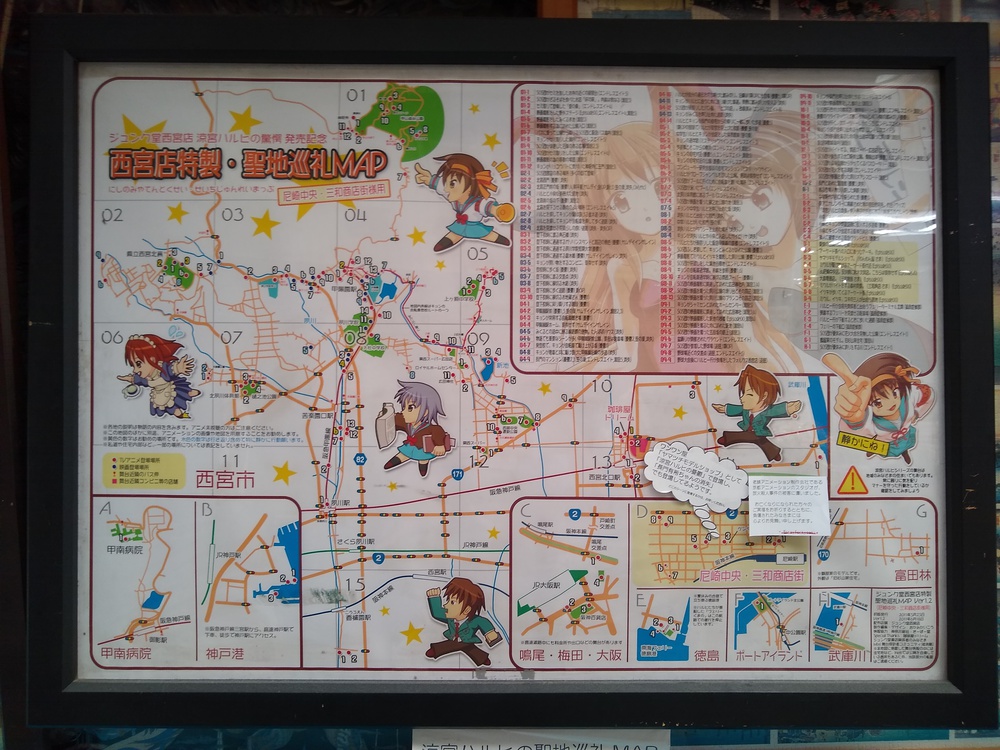

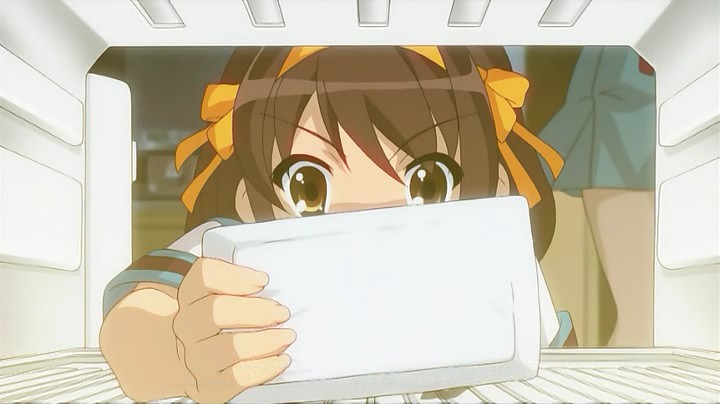

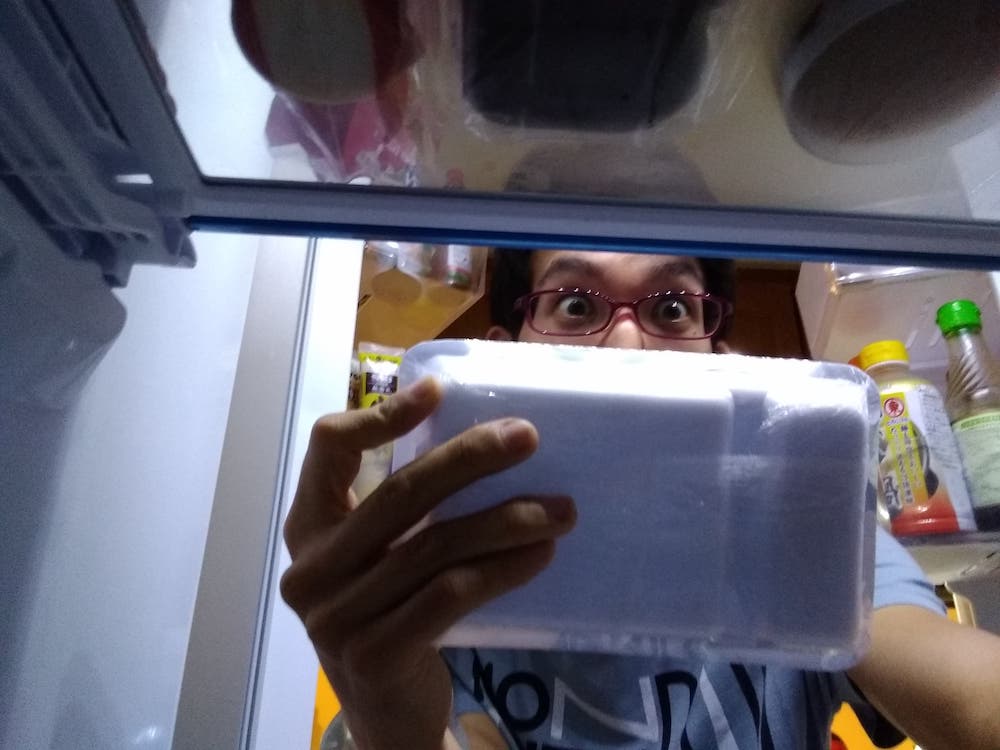

- Haruhi Suzumiya de Nagaru Tanigawa & Kyoto Animation (2003-2011, roman, anime, film)

- Paprika de Satoshi Kon (2006, film), adapté de Paprika de Yasutaka Tsutsui (1993, roman)

- Kaiba de Masaaki Yuasa (2008, anime)

- El secreto de sus ojos de Juan José Campanella (2009, film) adapté de La pregunta de sus ojos (2005, roman)

- The Tatami Galaxy de Masaaki Yuasa (2010, série) adapté de Chroniques mythiques de 4 tatamis et demi de Tomohiko Morimi (Yojouhan Shinwa Taikei, 2004, roman)

- Sherlock de Steven Moffat (2010-2017, série), adapté de Sir Arthur Conan Doyle

- “Fifteen Million Merits” de Charlie Brooker (2011, série Black Mirror)

- Puella Magi Madoka Magica de Gen Urobuchi (2011, anime et 2012, film, surtout Rebellion)

- Steins;Gate de Chiyomaru Shikura et al. (2011, série)

- Les Enfants loups, Ame & Yuki de Mamoru Hosoda (2012, film), je suis allé le voir 7 fois au cinéma…

- Psycho-Pass de Gen Urobuchi et al. (2012-2020, série et films)

- Le Vent se lève de Hayao Miyazaki (2013, film)

- Whiplash de Damien Chazelle (2014, film)

- Interstellar de Christopher Nolan (2014, film)

- Mommy de Xavier Dolan (2014, film)

- Hamilton de Lin-Manuel Miranda (2015, comédie musicale)

- Shouwa Genroku Rakugo Shinjuu de Haruko Kumota (2016, anime)

- Devilman Crybaby de Masaaki Yuasa (2018, anime) adapté de Devilman de Go Nagai (1972, manga) ; attention, cela risque de fortement heurter votre foi en l’humanité.

(… Mince, j’ai pas fini Lastman !!)

Divertissement

J’aimerais confirmer ces valeurs sûres en matière de divertissement dont vous avez certainement déjà entendu parler :

- Le Château de Cagliostro, le premier film de Hayao Miyazaki (1979) !

- Attack on Titan de Hajime Isayama (depuis 2009, manga et série)

- Fullmetal Alchemist: Brotherhood de Hiromu Arakawa (2009, série)

- Redline de Takeshi Koike (2009, film)

- Scott Pilgrim vs. the World d’Edgar Wright (2010, film), adapté de Bryan Lee O’Malley

- Lupin the Third: The Woman Called Fujiko Mine de Mari Okada, Sayo Yamamoto & Takeshi Koike (2012, série puis films) inspiré de Lupin the Third de Monkey Punch (1967, manga)

- Avril et le monde truqué d’Ekinci, Desmares et Legrand (2015, film) adapté de Jacques Tardi

- The Night is Short, Walk On Girl de Masaaki Yuasa (2017, film), également adapté de Tomohiko Morimi (2006, roman). Tout se déroule dans une unique nuit. Si vous connaissez Kyoto, vous apprécierez sans doute encore plus !

- Spider-Man: Into the Spider-Verse de Lord & Miller (2018, film)

- Parasite de Bong Joon-ho (2019, film)

Certaines d’entre elles sont classées meilleure dans sa catégorie, et c’est mérité.

Japon

D’autres, où le contexte a pu jouer, donc c’est très personnel et pas nécessairement généralisable ; certaines de ces œuvres nécessitent une connaissance fine de la culture japonaise pour être appréciées à leur juste valeur.

- Kids Return de Takeshi Kitano (1996, film)

- Millennium Actress de Satoshi Kon (2001, film)

- Time of Eve de Yasuhiro Yoshiura (2008, anime)

- March Comes in Like a Lion de Chica Umino & Shaft (2016, anime)

- The Third Murder de Hirokazu Kore-eda (2017, film)

- Fireworks de Shaft (2018, film) adapté de Fireworks de Shunji Iwai (1993)

Avant la décade

Blake & Mortimer (1946), XIII (1984), Porco Rosso (1992), Léon (1994), 12 Monkeys (1995), Gattaca (1997), GTO (1997), I”s (1997), The Truman Show (1998), American Beauty (1999), Death Note (2003), Oldboy (2003), etc.

Et vous ? Quelles sont vos œuvres préférées ?